Day 18: 人工神经网路初探 前馈神经网路

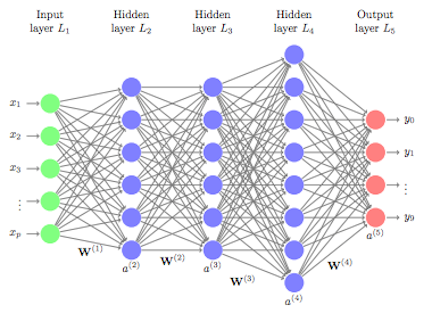

Feedforward 前馈神经网路

前馈神经网路是一种neuron之间的连接并不形成循环的人工智慧网路。

前馈神经网路是最简单的神经网路,在这个网路中,资料流动的方向是同个方向(往前),由输入层开始,流向隐藏层,再流到输出层。这样的网路中并没有回送或者反馈机制。

Error Function

Error是指期待结果与预测结果之间的差值。

神经网路的学习目标是计算出最优化的权重值。当误差达到最小值(理想上是零),这个权重被认为对於给定的数据集而言是最优化的。我们见过当网路开始学习处理,它初始化权重且使用其中一个activation functions计算每个neuron的输出。然後便会计算误差、调整权重、计算输出且重新计算误差然後拿来比较之前计算的误差,直到找到最小化的误差。给出最小误差值的权重便会被当作最终的权重,在此阶段该网路也会被视为已学习。

以微积分来看,假如函数的一阶导数是零,则这个函数不是最小值就是最大值。找到这个导数为零的最小值就是我们训练神经网路的目标。

因此,神经网路必须具有误差函数,该函数将计算一阶导数并找到误差函数最小的点(权重与bias),选择误差函数的基准便是看要训练的模组是什麽型态的。

误差函数通常也被称做损失函数(Loss function),或简称损失(Loss)。

资料参考:

https://afit-r.github.io/feedforward_DNN

<<: Day 24 : 负责任的 AI - Responsible AI (RAI)

>>: [火锅吃到饱-8] 鲜友火锅 Shian-Yeou Hot Pot - 台中太平店

Day29 - 使用Keystore加密密码

今天要来处理储存密码的安全问题。 话是这麽说,但要明白即使我们将密码加密储存了,但在使用过程中依旧会...

DAY12支持向量机演算法(续一)

昨天介绍完SMO算法第一步,今天就要来写这个方法第二步, 而第2步步骤:选取两个点,并计算上下界H和...

以Postgresql为主,再聊聊资料库 PostgreSQL复制schema下table结构到另一schema的procedure及取样的研讨

在资料库的日常使用,会有将schema下的table结构复制到另一schema下,供做测试,或是做移...

案例:在AWS上透过SageMaker跟CodePipeline驾驭MLOps的参考架构(上)

在经历了几篇的MLOps基础概念之後,想在後面的文章带大家看看几个案例。透过案例来学习,会对专案在技...

改造你的VSCode,大幅提升你的Coding效率

工欲善其事,必先利其器,插件是Coding效率提升的利器 今天要来介绍的主角是Visual Stud...