Day 22 - 天眼CNN 的耳朵和嘴巴 - RNN(3) -GRU

GRU vs. LSTM

LSTM 在一个单一单元中要完成很多的操作。当使用更大的网络时,与循环神经网络RNN相比,训练时间将显着地增加。如果想要减少你的训练时间,但同时也使用一个能记住长期依赖关系的网络,那麽还有另一个替代LSTM网络的方法,它被称为门控循环单元(GRU)。

原文网址

Gated Recurrent Unit (GRU)

LSTM 有个问题就是执行速度较慢,GRU 则是在 2014 年由韩国科学家 Kyunghyun Cho 在加拿大蒙特罗大学於 Yoshua Bengio 实验室做博士後研究时所发表,用来加快执行速度及减少记忆体的耗用。

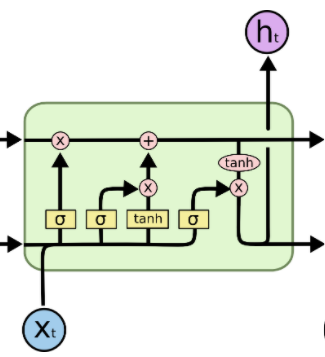

再看一下LSTM : Understanding LSTM Networks

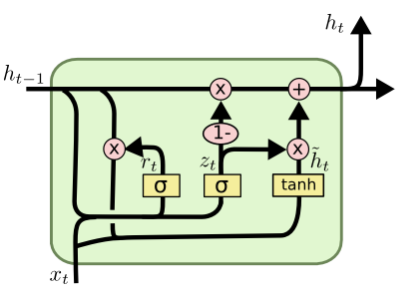

门控循环单元 GRU

GRU 则将 LSTM 中的遗忘门 (forget gate) 与输入门 (input gate) 用一个更新门 (update gate) 取代,并把单元状态 (cell state) 和隐藏状态 (ht) 进行合并,计算新资讯的方式和 LSTM 也有所不同。与LSTM网络不同的是,GRU没有单元状态,并且有2个门而不是3个(忘记、更新和输出)。

GRU使用一个更新门和一个重置门。更新门决定了应该让多少之前的信息通过,而重置门则决定了应该丢弃多少之前的信息。 在上面的图中,z_t表示更新门操作,通过使用一个sigmoid函数,我们决定让哪些之前的信息通过。h_t表示重置门操作,我们将前一时间步骤和当前时间步骤的连接值与r_t相乘。这将产生我们希望从前一时间步骤中所放弃的值。

尽管门控循环单元在计算效率上比LSTM网络要高,但由於门的数量减少,它在表现方面仍然排在LSTM网络之後。因此,当我们需要更快地训练并且手头没有太多计算资源的情况下,还是可以选择使用门控循环单元的。

原文网址

这部影片link则用详细的步骤来拆解 GRU,值得一看。

比较长短期记忆模型 (LSTM) 与改良後的递归神经网路模型:GRU

注:本文是搜寻数个网站及各种不同来源之结果,着重在学习,有些内容已难办别出处,我会尽可能列入出处,若有疏忽或出处不可考,请联络我, 我会列入, 尚请见谅。

>>: 服务组织控制(Service Organization Control :SOC)

人脸辨识-day20 资料预处理--1

在做模型训练时,要先将训练资料做一些事前的处理,为以下这几类:资料平衡、异常点处理、缺失值处理、特徵...

Day 32:来呼叫星战 Profile List 下一页吧(1/2)

在 Day 31 分享 RecyclerView 如何载入更多之後,先来帮大家回顾之前星战的 Pro...

入门魔法 - 变数与值

前情提要 艾草:「好了,现在我们可以开始入门魔法课程 JavaScript 变数与值的教学罗!」 「...

Python 演算法 Day 10 - Feature Selection

Chap.II Machine Learning 机器学习 https://yourfreetemp...

[Angular] Day13. Built-in directives - attribute

在介绍完 component 与 template 後,接着要来介绍什麽是 dierctive,可能...