Day 4 - 类神经网路(二)

形式神经元变形

(原文网址:https://kknews.cc/tech/z34j3rg.html)

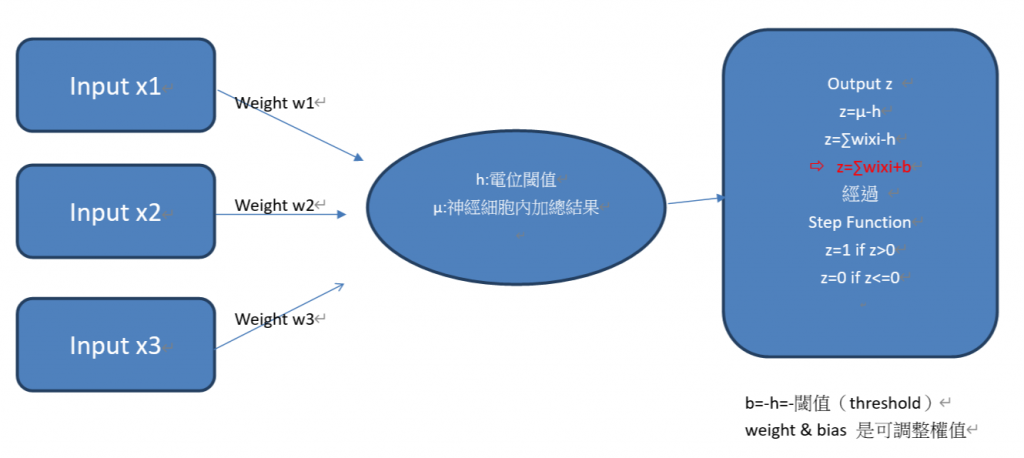

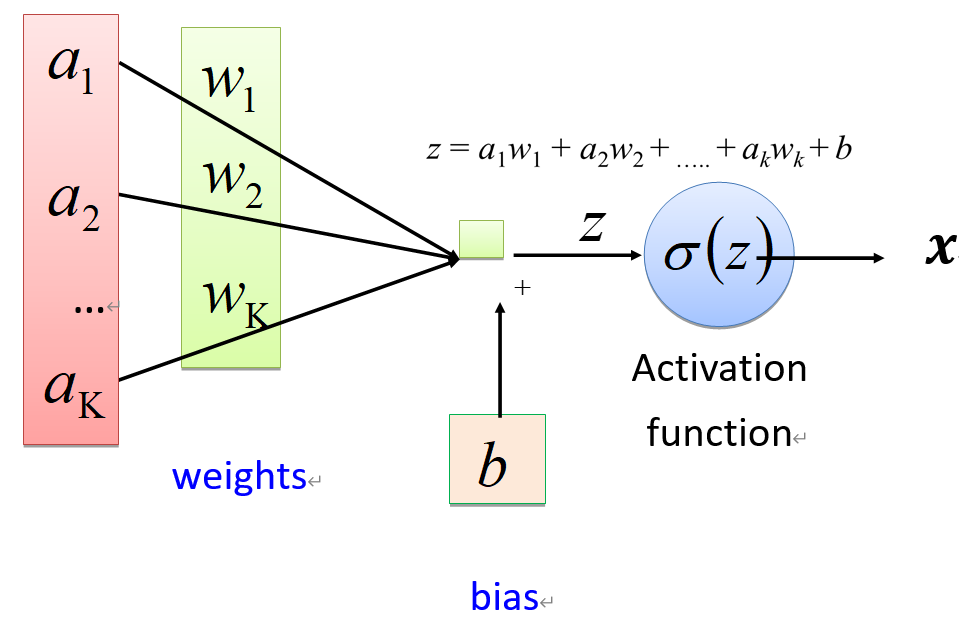

- 目前常用的神经元形式,是上述模型的一个简单变形,把阈值(threshold)变成偏置(b,bias)就可以得到。

形式神经元加上感知器(Perceptron)

(原文网址:https://kknews.cc/tech/z34j3rg.html )

- 单层神经网络 :首个可以学习的神经网络

- 1958年,Rosenblatt提出了一种由两层神经元组成的神经网络--感知机模型(Perceptron),它是首个可以学习的神经网络

- 与神经元模型重大区别在於感知机的参数并不是事先设定的而是训练得到的,具体做法是通过在MCP模型的基础上使用损失函数(loss function),通过降低损失函数值就可以更新参数。学习参数的过程在几何上是在学习「决策分界」。即在二维的数据平面中学得一条直线,3维的数据平面中学得一个平面,n维的数据平面中学得n-1维的超平面。

- 1962年,单层感知机模型的收敛性得到理论证明。

- 多层感知机(MLP):非线性分类

- Minsky指出单层神经网络无法解决异或问题。虽然,通过增加中间的计算层多层神经网络就可以解决异或问题,而且还具有非常好的非线性分类效果。不过Minsky认为如果将计算层增加到多层会导致计算量过大,也没有有效的学习算法,所以研究更深层的网络是没有价值的。

- 1986年,神经网络研究迎来了转机,Rumelhar和Hinton等人提出了着名的反向传播(Backpropagation,BP)算法,解决了多层神经网络产生的复杂计算量问题,人工神经网络的研究迎来复苏。

从此开启”多层感知机(MLP) “

多层感知机(MLP)

(原文网址:https://kknews.cc/tech/z34j3rg.html)

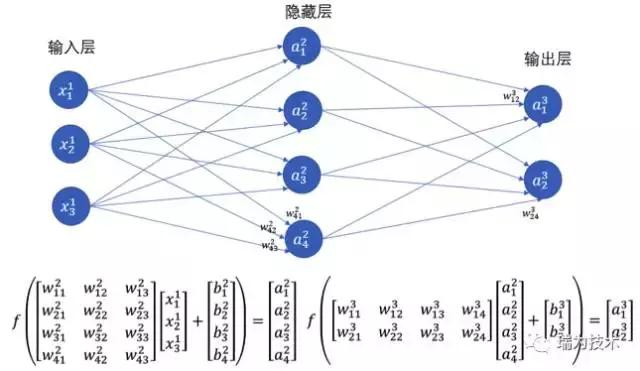

- 普通的多层神经网络也叫做多层感知机(MLP),它是在输入层,输出层的基础上又增加了做计算的隐藏层(在输入层与输出层之间所以称作「隐藏」层)。理论证明,多层神经网络可以无限逼近任意连续函数,也就是说,面对复杂的非线性分类任务也可以分类的很好。

- 结构如下:

注:本文是搜寻数个网站及各种不同来源之结果,着重在学习,有些内容已难办别出处,我会尽可能列入出处,若有疏忽或出处不可考,请联络我, 我会列入, 尚请见谅。

[05] [Flask 快速上手笔记] 04. HTTP 方法x静态文件x渲染模板

HTTP 方法 在预设情况下 Flask 路由的 HTTP 方法只允许 GET 可以透过route(...

Day 13. 模板语法Template Syntax – 插值 v-once、v-html

昨天我们讲了Vue的一生,今天来说说模板语法,看看要怎麽把vue instance中的资料变化渲染到...

[day20]谈购物流程设计

本来想除了管理功能外全部都在Line介面里面解决,但做了一阵子觉得越想越不对劲,重新考量了一下思路,...

机器学习:演算法

线性代数 LR:逻辑回归(Logistic Regression): 预测事件发生的机率(y=1)...

Ruby on Rails Find Find_by Where 差别

find方法 回传带入的参数与primary key(流水编号id)相同的资料。 找到primary...