Day 15: 人工神经网路初探 激活函数(下)

激活函数 Activation Function

Scaled Exponential Linear Unit 比例指数线性单元

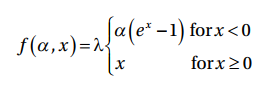

Scaled exponential linear unit (SELU)使用函数计算neuron的输出:

其中λ = 1.05070098 和? = 1.673263,这些数值是固定的且在backpropagation期间也不会改变。

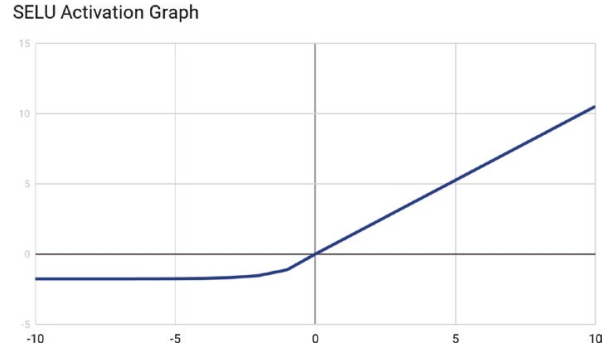

SELU拥有自行正规化的属性,SELU生成的输出皆是均衡值0与标准差1进行正规化。

为何需要在意产生正规化的输出呢? lecun_normal初始化函数将网路的参数初始化为正态分布或高斯分布。SELU也会产生正规化的输出,这表示整个网路存在正规的行为,因此最後一层的输出也会是正规化的。

借助SELU,学习能力方常强大且允许训练有多层的网路。

由於SELU的整个网路架构是自我正规化,计算非常有效率且倾向快速收敛。另一个好处是它能够克服当输入特徵太高或太低时,梯度爆炸或消失的问题。

Softplus Activation Function

Softplus Activation Functionu对函数值z进行平滑处理。

Softplus Activation Function也被称呼为SmoothReLU function。

Softplus的一阶导函数是1/(1+e-z) ,与sigmoid activation function相同。

Softmax

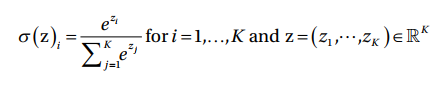

Softmax是一种利用实数的输入向量,将资料正规化为机率分布,并产生介於0至1的输出

且输出之总和为1的函数。

Softmax是最常被使用於分类神经网路的最後一层(输出层)的激励函数,结果将会被编译成每个类别的预测机率。

Softmax的转换是使用此函数作计算:

接下来会介绍损失函数 Loss function~

硬碟上的资料是否有重量?

我的学生前些日子突然脑洞爆发,问我:“存满资料的硬碟是不是比空硬碟重?资料是否有重量?” 我也查了大...

Day28 [实作] 一对一视讯通话(8): Docker compose 整合 TURN Server

前面的实作中,我们都是使用 google 提供的 STUN server,在 後疫情时代的 WebR...

Nice day 29 (iphone10s 功能挖掘)-好用捷径介绍

前言 随着时间的流逝,整个活动也接近了尾声,但在真正结束前都还是要好好地发表,今天笔者想为各位介绍一...

Day 25 递回神经网路 RNN 、梯度下降与梯度消失

介绍 递回神经网路 RNN (recurrent neural networks)是神经网路的一种,...