课堂笔记 - 深度学习 Deep Learning (19)

- Gradient Descent Method

统整一下到底要如何Gradient Descent去计算Logistic Regression:

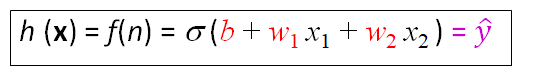

首先我们有输入值x1,x2,y,用输入值带入active function可以得到y-hat:

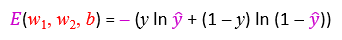

还有error function的参数w1,w2,b,

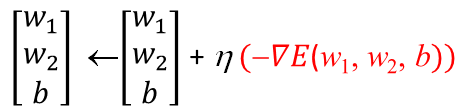

然後就可以用梯度下降去获得Net input了(也就是上一篇的那个偏微分) eta表示learning rate (校正幅度)

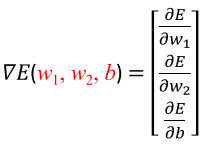

如何找到梯度下降的偏微分曲线>>

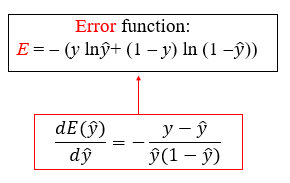

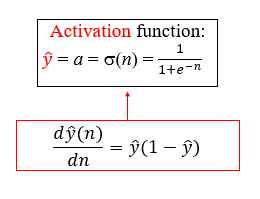

首先找到E,也就是error function:

有了E,接下来找y-hat:

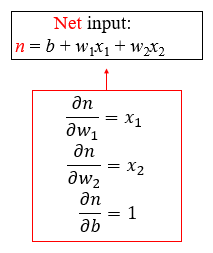

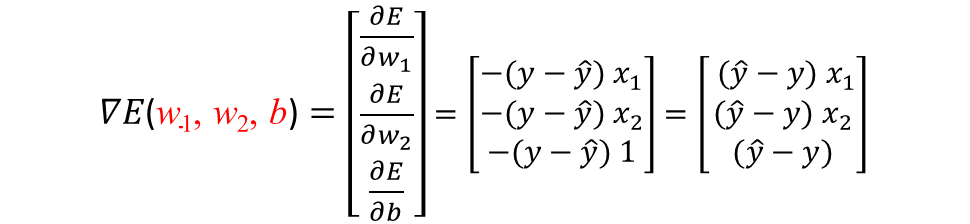

最後就可以得到:

接下来就会发现他们的相互关系然後用y跟y-hat去替换:

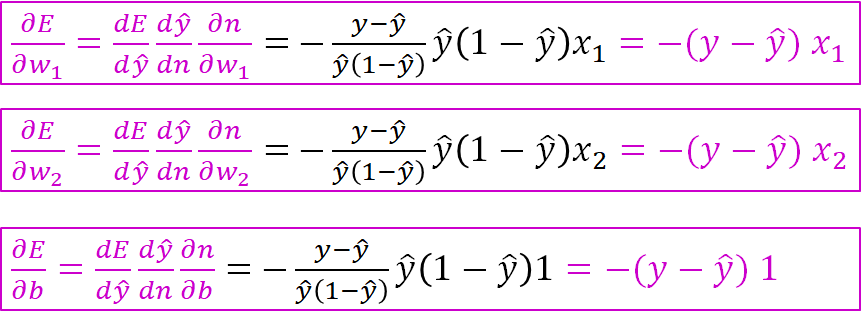

也就是说梯度下降的偏微分曲线长这样:

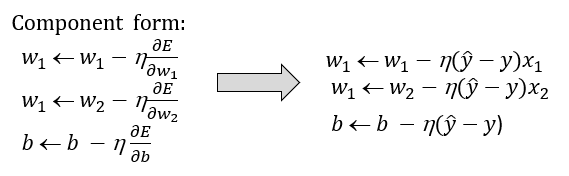

数学式表示:

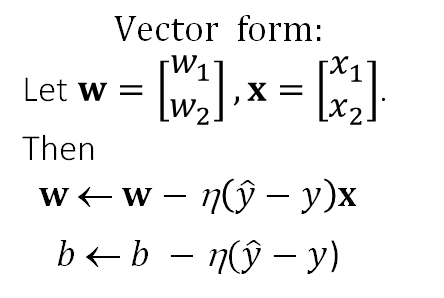

向量式表示:

这就是如何用Gradient Descent去计算Logistic Regression了。

<<: 课堂笔记 - 深度学习 Deep Learning (18)

DAY28: 运算是什麽?

...

伸缩自如的Flask [day 20] Docker compose

假设今天有的flask服务要附上能一起使用的DB,可以考虑使用Docker compose这个服务。...

[Day 12] 从 tensorflow.keras 开始的 MobileNet 生活

0. 进度条 模型 进度 VGG Net 完成 ResNet 完成 DensNet 完成 Mobil...

【後转前要多久】# Day04 HTML - 元素属性、以及Emmet语法

tag巢状结构 tag底下是可以再包tag的、底下可以再包tag... 昨天也看到一些例子如<...

7.移转 Aras PLM大小事-汇入Aras如何有效执行

关於汇入工具这档事情,我自己是重新写了一支汇入程序 主要是原厂提供的程序并不好用 1.Log记录档不...