【Day 24】 实作 - 创建 AWS Kinesis Data Firehose for WAF

今天我们要来实作 - 『如何启用 WAF 日志以及汇入 BI 进行分析』,

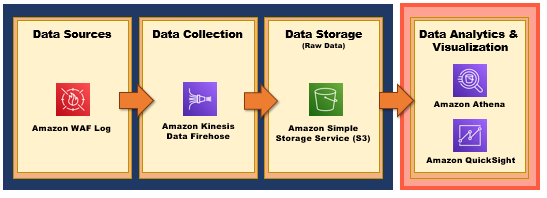

Data Analytics Pipeline 如下图所示:

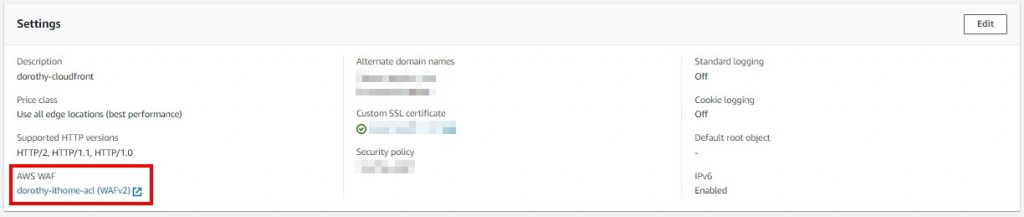

再做这个实作之前,大家要先部属 AWS WAF 至 CloudFront 上喔 ~

那再启用 WAF Log 之前,我们必须要先建立 AWS Kinesis 服务,那我们就开始吧 GOGO

建立Kinesis Data Firehose

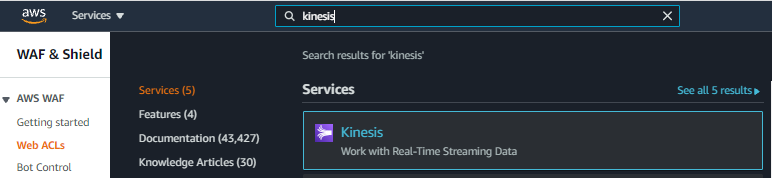

步骤一、搜寻 AWS 服务:Kinesis

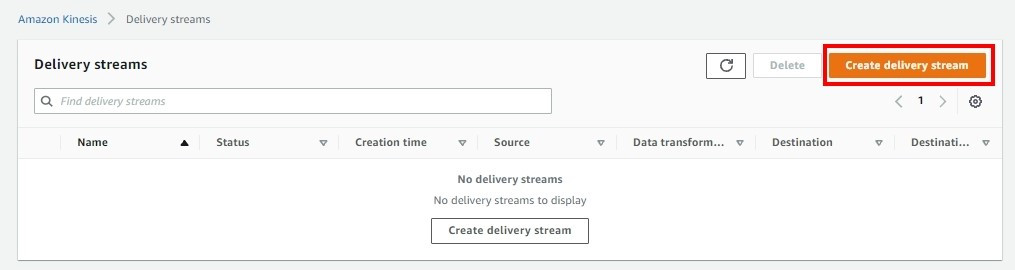

步骤二、点选 Create Delivery streams

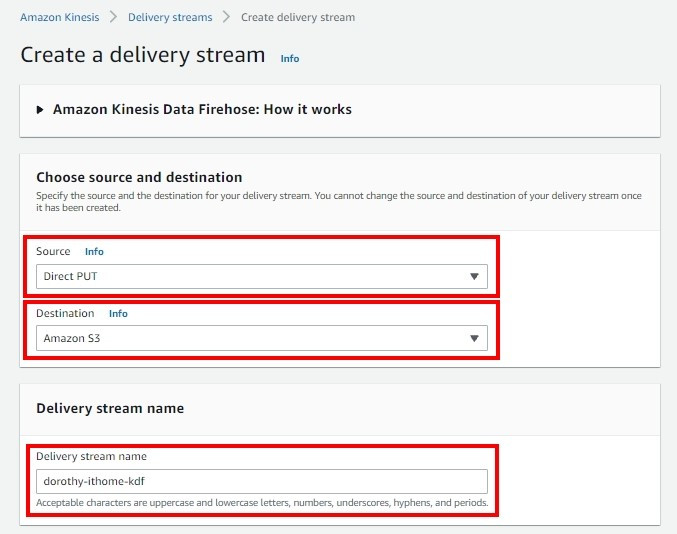

步骤三、设定来源以及目的端

- Source:Direct PUT

- Destination:选择 AWS S3

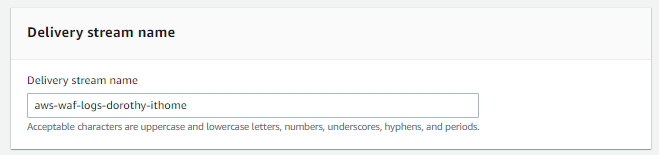

- Delivery stream name:务必要输入『aws-waf-logs-』前缀词,不然 AWS WAF 读不到这只 Kinesis

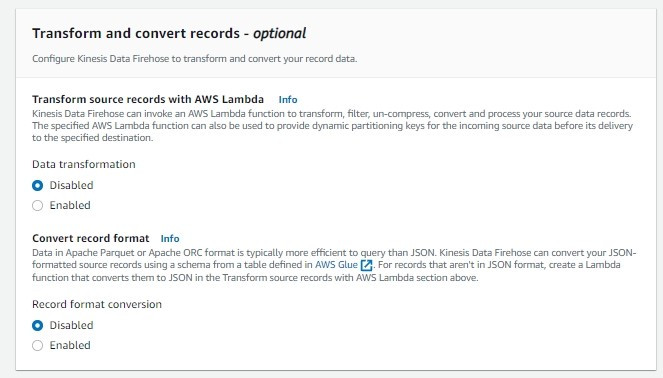

步骤四、资料的处理与转换设定

- Transform source records with AWS Lambda:若启用的话可以使用 AWS Lambda 来进行资料处理,那我们没有要进行资料处理,所以我这边先选择 Disabled

- Convert record format:这边可以设定进行资料格式转换( JSON >> Apache Parquet、Apache ORC ),这边选择 Disabled 即可

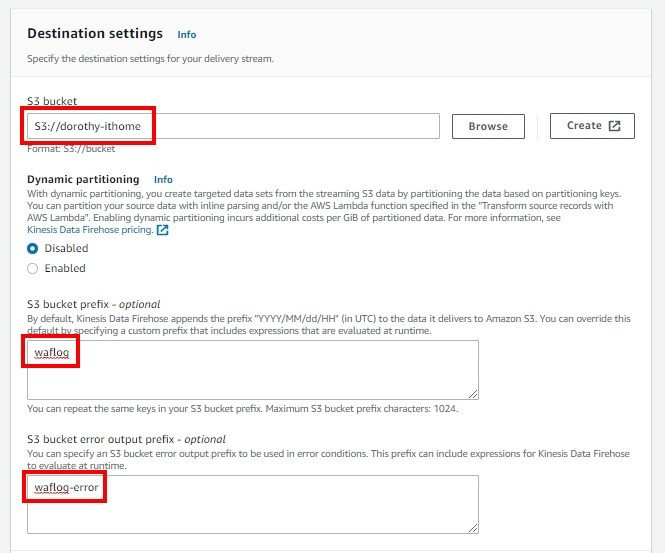

步骤五、目的端设定

- S3 bucket:选择先前创的 S3 Bucket

- Dynamic Partitioning:S3 bucket prefix:这里存放 waf log 资料夹的地方

- S3 bucket error output prefix:这里存放若 kinesis 撷取执行失败,会将 Error Log 存在此资料夹

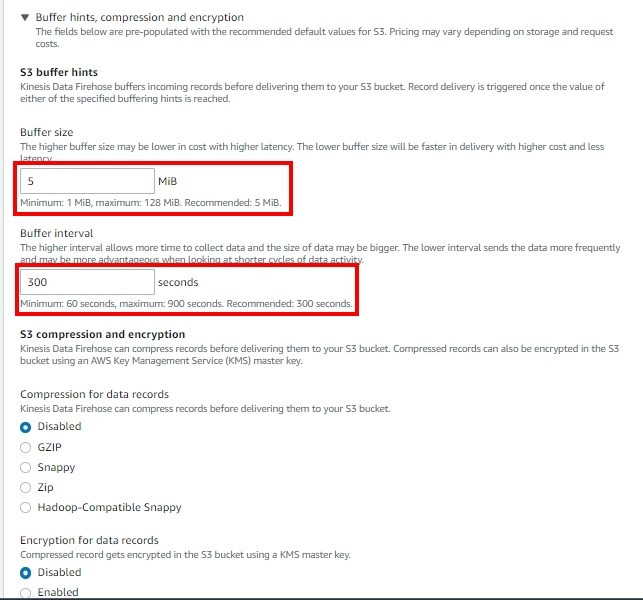

步骤六、点选 Buffer hints, compression and encryption,

Buffer size 跟 Buffer interval 就是如果当 Buffer 超过 5 MiB或者超过 300 秒後会将串流资料丢到 AWS S3上

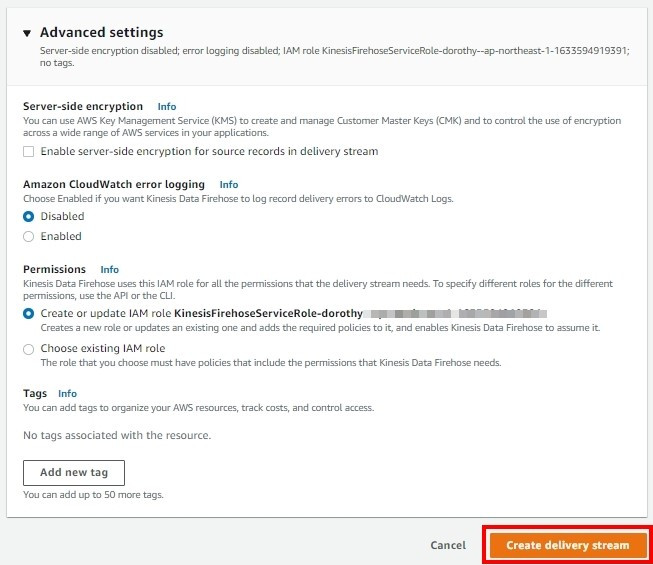

步骤七、点选 Advanced settings

- Server-side encryption:支援使用 AWS Key Management Service 进行 Amazon S3 服务器端加密

- Amazon CloudWatch error logging:如果有启用资料转换,Kinesis Data Firehose 可以将资料传输错误发送到 CloudWatch Logs,那我们没有启用,故选择 Disabled

- Permissions:授予 Kinesis 可以使用的权限

接着确认无误後按 Create delivery stream

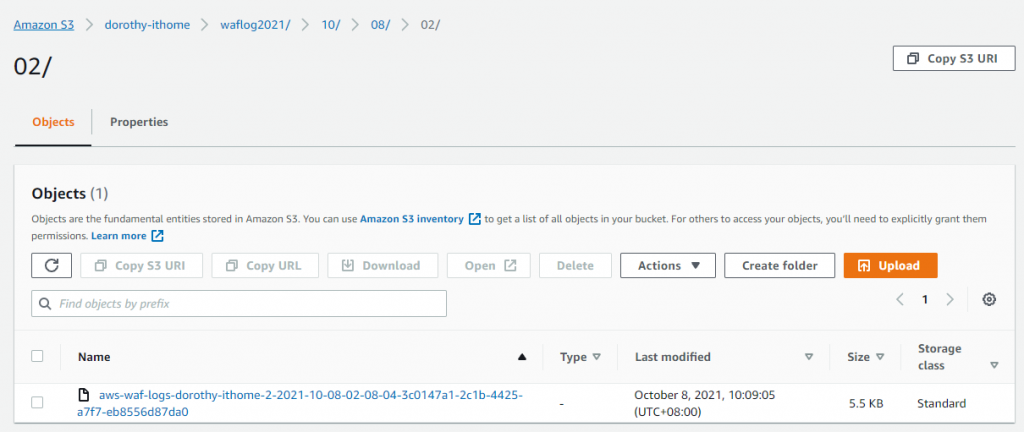

今天我们顺利建立好 AWS Kinesis Data Firehose,那大家就可以看到 AWS S3 已顺利产生资料也~

明天我们就会来讨论『如何启用 WAF 日志』,明天见罗 : D ~

如果有任何指点与建议,也欢迎留言交流,一起漫步在 Data on AWS 中。

参考&相关来源:

[1] Kinesis Data Firehose

https://docs.aws.amazon.com/firehose/latest/dev/create-configure.html

<<: 30天打造品牌特色电商网站 Day.22 图片排版实作

>>: Day 25 [Python ML、资料清理] 处理遗失值

【C#】Creational Patterns Simple Factory Mode

简单工厂模式,顾名思义就是抽象工厂的简单版~ 共有三个环节~ 分别是 抽象产品、具体产品、生产产品~...

[Day8] 关於人脸侦测(Face Detection)的二三事

本篇文没有引言,不罗嗦。 本文开始 人脸侦测是物体侦测(Object Detection)的一种;...

Day 10:新手杀,谁来教我离开 vim 阿~~

前面 9 天都在介绍操作环境,今天终於要进到编辑器啦!我选用的编辑器是 nvim,但是如果你要用 v...

LeetCode解题 Day08

848. Shifting Letters https://leetcode.com/problem...

GCP Container Registry 发生 image tag 为空白的原因及列出空白 tag image 的方法

一般来说,如果是透过GCP官网的介绍方式,透过 docker 指令推送 image 到 GCP Co...